Искусственный интеллект научили самостоятельно социализироваться

Icma.az, ссылаясь на сайт Vesti, передает.

ИИ-агенты способны формировать социальные нормы без вмешательства человека — исследование

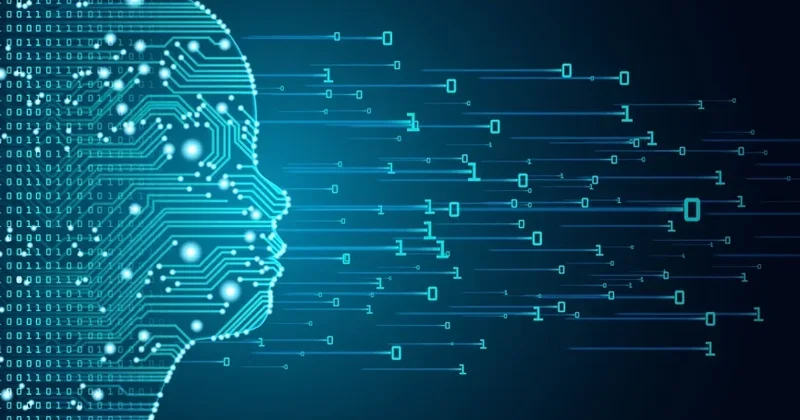

Модели с искусственным интеллектом, основанные на больших языковых алгоритмах, могут не только взаимодействовать друг с другом, но и формировать коллективные социальные соглашения. К такому выводу пришла международная группа ученых из Великобритании, Дании и Гренады.

Как передает Vesti.az, результаты их работы опубликованы в Science Advances.

В отличие от прежних исследований, где LLM (большие языковые модели) рассматривались изолированно, в этот раз учёные сосредоточились на поведении группы ИИ-агентов. Эксперименты показали, что в процессе общения, например, между моделями вроде ChatGPT, участники не просто следуют инструкциям, а демонстрируют признаки самоорганизации и достижения консенсуса — аналогично человеческим сообществам.

Каждому из агентов предлагалось выбрать «имя» (букву или набор символов) из общего набора. При совпадении выбора оба получали поощрение, при расхождении — штраф. Уже спустя несколько итераций ИИ вырабатывали общее соглашение, без центрального управления или заранее заданной логики.

Учёные также зафиксировали, что у агентов могут возникать коллективные предубеждения, а их «социальные нормы» оказываются нестабильными. Маленькие, но целенаправленные группы ИИ способны изменить установившиеся соглашения — аналогично «переломным моментам» в человеческих обществах.

Исследование открывает новые перспективы для понимания группового поведения ИИ и потенциальных рисков, связанных с их внедрением в реальную социальную и техническую среду.

Другие новости на эту тему:

Другие новости на эту тему: Просмотров:140

Просмотров:140 Эта новость заархивирована с источника 16 Мая 2025 18:31

Эта новость заархивирована с источника 16 Мая 2025 18:31

Войти

Войти

Online Xəbərlər

Online Xəbərlər Новости

Новости Погода

Погода Магнитные бури

Магнитные бури Время намаза

Время намаза Калькулятор колорий

Калькулятор колорий Драгоценные металлы

Драгоценные металлы Конвертор валют

Конвертор валют Кредитный калькулятор

Кредитный калькулятор Курс криптовалют

Курс криптовалют Гороскоп

Гороскоп Вопрос - Ответ

Вопрос - Ответ Проверьте скорость интернета

Проверьте скорость интернета Радио Азербайджана

Радио Азербайджана Азербайджанское телевидение

Азербайджанское телевидение О нас

О нас

TDSMedia © 2026 Все права защищены

TDSMedia © 2026 Все права защищены

Самые читаемые

Самые читаемые