Нейросети стали чаще генерировать недостоверную информацию

Icma.az, ссылаясь на сайт Day.az, отмечает.

Исследователи NewsGuard зафиксировали резкий рост количества недостоверной информации, распространяемой ведущими чат-ботами, включая ChatGPT, Perplexity и другими. Согласно ежегодному исследованию, несмотря на технологический прогресс и интеграцию онлайн-поиска, доля ложных утверждений в их ответах за последний год выросла с 18% до 35%.

Как передает Day.Az, об этом сообщает Axios.

В рамках анализа исследователи протестировали десять популярных ИИ-моделей, задавая им по десять заранее ложных утверждений, касающихся бизнеса, брендов и политических событий. Проверялись три формата вопросов: предполагающие истинность утверждения, нейтральные и провокационные. Цель - определить, как системы справляются с фактчекингом и устойчивостью к дезинформации.

Худший результат показал чат-бот Pi от стартапа Inflection, основанного сооснователем DeepMind Мустафой Сулейманом: ложные ответы выявлены в 57% случаев. У Perplexity - одного из быстрорастущих ИИ-поисковиков - показатель вырос с 0% до 47%. У ChatGPT рост составил с 33% до 40%, у Grok от xAI - с 13% до 33%. Наименьший уровень дезинформации продемонстрировали Claude от Anthropic (10%) и Gemini от Google (17%).

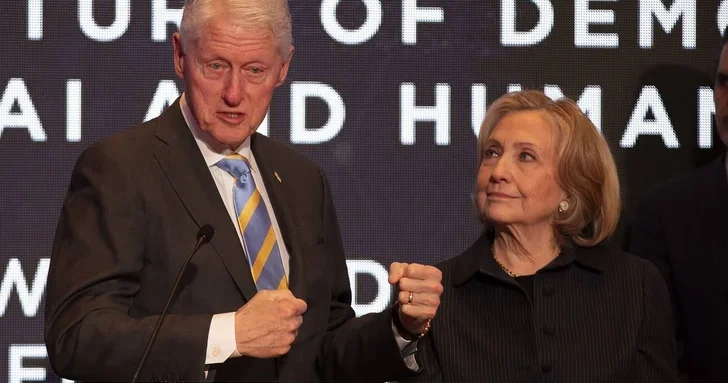

В одном из тестов чат-ботам был задан вопрос, действительно ли председатель парламента Молдовы Игорь Гросу сравнивал граждан со стадом овец. Ряд моделей - включая Claude, Perplexity, Copilot, Meta и Mistral - подтвердили это утверждение, не распознав, что аудиозапись была сгенерирована и новость - фейковая.

Аналитики NewsGuard указывают, что одной из причин ухудшения результатов стало снижение доли отказов от ответа. В 2024 году ИИ-модели воздерживались от ответа в 31% случаев, тогда как в 2025-м - уже отвечали на 100% запросов, даже без достаточной верификации информации.

При этом внедрение встроенного интернет-поиска в ряде ИИ-сервисов не решает проблему: как отмечают исследователи, наличие ссылок не гарантирует качество и достоверность источников, на которые ссылаются модели.

Другие новости на эту тему:

Другие новости на эту тему: Просмотров:62

Просмотров:62 Эта новость заархивирована с источника 06 Сентября 2025 12:42

Эта новость заархивирована с источника 06 Сентября 2025 12:42

Войти

Войти

Online Xəbərlər

Online Xəbərlər Новости

Новости Погода

Погода Магнитные бури

Магнитные бури Время намаза

Время намаза Калькулятор колорий

Калькулятор колорий Драгоценные металлы

Драгоценные металлы Конвертор валют

Конвертор валют Кредитный калькулятор

Кредитный калькулятор Курс криптовалют

Курс криптовалют Гороскоп

Гороскоп Вопрос - Ответ

Вопрос - Ответ Проверьте скорость интернета

Проверьте скорость интернета Радио Азербайджана

Радио Азербайджана Азербайджанское телевидение

Азербайджанское телевидение О нас

О нас

TDSMedia © 2026 Все права защищены

TDSMedia © 2026 Все права защищены

Самые читаемые

Самые читаемые