NVIDIA раскрыла секрет ускорения биологических трансформеров

Как передает Icma.az со ссылкой на сайт Day.az.

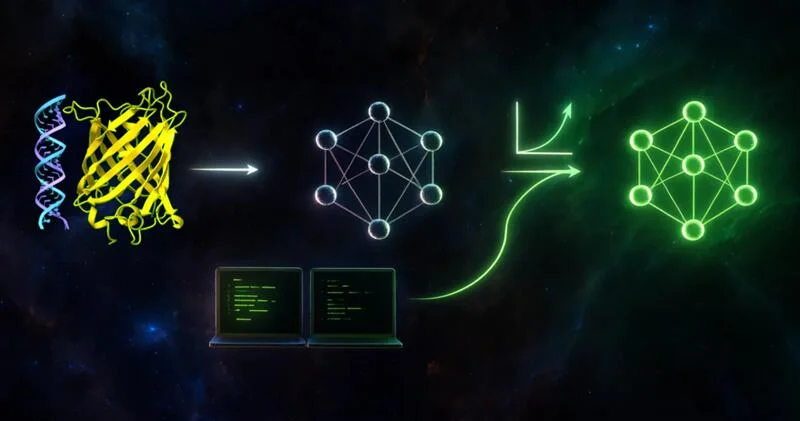

NVIDIA опубликовала подробный гайд по масштабированию биологических моделей, показывая, как эффективнее использовать ресурсы GPU и ускорять обучение больших трансформеров.

Как сообщает Day.Az со ссылкой на Хабр, основная идея сводится к трём ключевым подходам, каждый из которых решает конкретные проблемы при работе с массивными моделями биологических последовательностей.

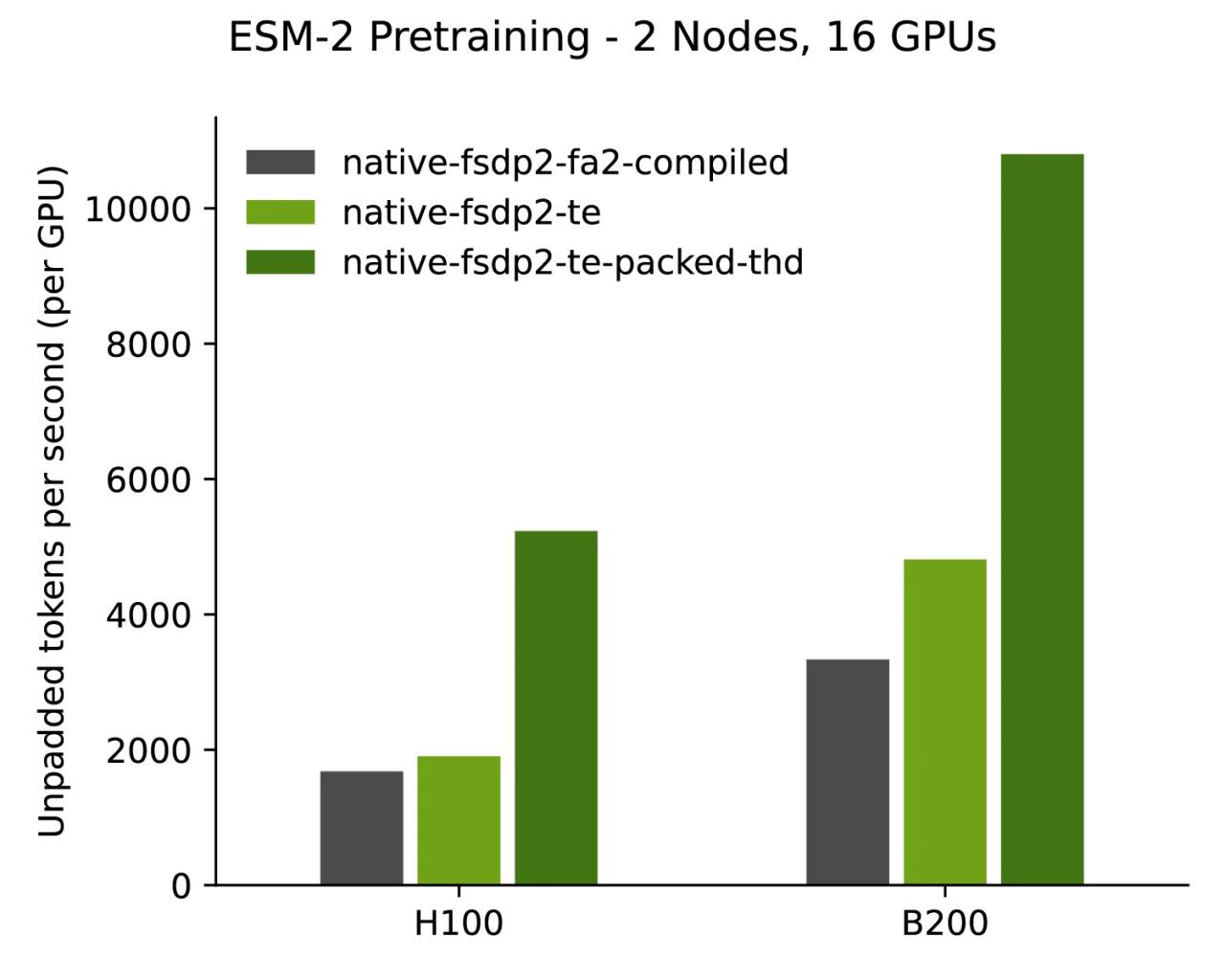

Первый подход - Transformer Engine. Он подменяет стандартные блоки на оптимизированные версии, которые требуют меньше памяти и быстрее выполняют матричные операции. При этом поддерживаются форматы FP8 и FP4, что позволяет ускорять обучение и инференс без потери точности. Другими словами, это готовое решение для ускорения работы трансформеров с огромными биологическими датасетами.

Второй подход - масштабирование обучения до миллиардов параметров. С помощью FSDP и гибридных режимов параллелизма модель можно разнести по нескольким GPU или узлам, без необходимости вручную собирать сложную конфигурацию. NVIDIA подробно показывает, как правильно распределять вычисления и синхронизировать градиенты, чтобы использовать ресурсы максимально эффективно.

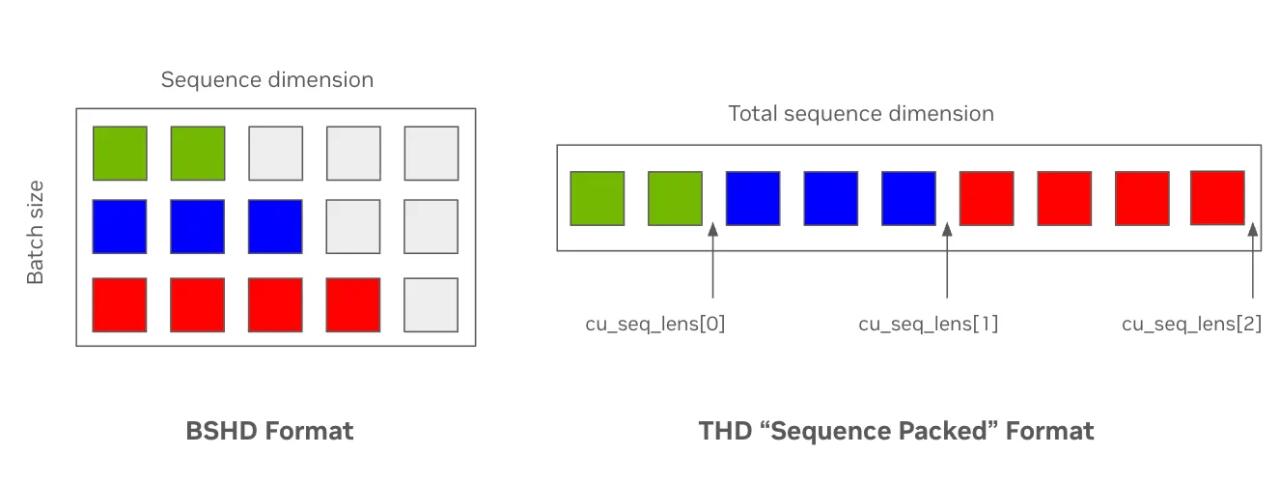

Третий подход касается экономии памяти за счёт sequence packing. Биологические последовательности сильно различаются по длине, и при стандартной обработке половина батча оказывается заполнена паддингами. Packing позволяет сжимать батчи, удаляя пустые токены, что повышает скорость и снижает потребление VRAM. Этот метод особенно полезен при работе с длинными последовательностями ДНК, РНК и белковых цепочек, где эффективность памяти критична.

Чтобы не писать вручную CUDA-ядра и не тратить время на низкоуровневую оптимизацию, NVIDIA предлагает использовать BioNeMo Recipes. Это готовые решения на базе привычного стека PyTorch и HuggingFace, которые позволяют получить производительность уровня крупных фреймворков, не отказываясь от гибкости и удобства Python. Пользователи могут сразу запускать масштабные биологические трансформеры и получать стабильные результаты без глубокого погружения в оптимизацию GPU.

Другие новости на эту тему:

Другие новости на эту тему: Просмотров:45

Просмотров:45 Эта новость заархивирована с источника 23 Ноября 2025 06:16

Эта новость заархивирована с источника 23 Ноября 2025 06:16

Войти

Войти

Online Xəbərlər

Online Xəbərlər Новости

Новости Погода

Погода Магнитные бури

Магнитные бури Время намаза

Время намаза Калькулятор колорий

Калькулятор колорий Драгоценные металлы

Драгоценные металлы Конвертор валют

Конвертор валют Кредитный калькулятор

Кредитный калькулятор Курс криптовалют

Курс криптовалют Гороскоп

Гороскоп Вопрос - Ответ

Вопрос - Ответ Проверьте скорость интернета

Проверьте скорость интернета Радио Азербайджана

Радио Азербайджана Азербайджанское телевидение

Азербайджанское телевидение О нас

О нас

TDSMedia © 2026 Все права защищены

TDSMedia © 2026 Все права защищены

Самые читаемые

Самые читаемые