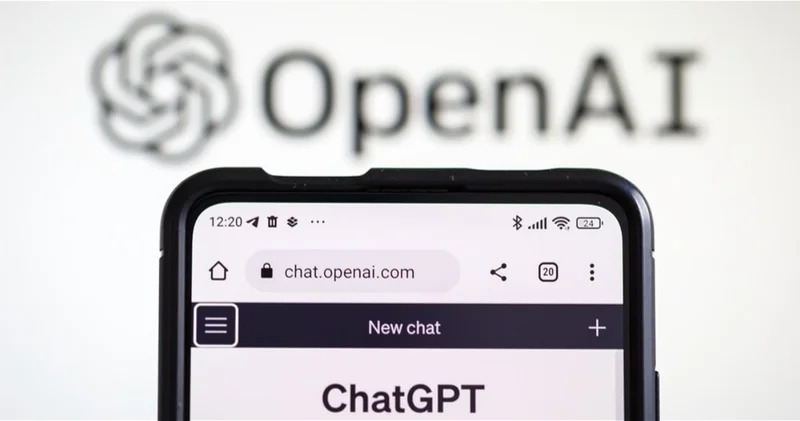

OpenAI раскрыла масштабы обращений пользователей ChatGPT в состоянии кризиса

По данным сайта 1news.az, передает Icma.az.

OpenAI впервые опубликовала внутренние оценки, касающиеся пользователей ChatGPT, демонстрирующих признаки возможных психических кризисов, начиная от мании и психоза до суицидальных мыслей.

Компания заявляет, что такие случаи крайне редки, однако эксперты по психическому здоровью выражают обеспокоенность масштабом проблемы.

Согласно отчету OpenAI, около 0,07% активных пользователей ChatGPT в неделю демонстрируют признаки чрезвычайных ситуаций, связанных с психическим здоровьем. Если учесть, что, по словам главы компании Сэма Альтмана, еженедельно ChatGPT используют около 800 миллионов человек, речь может идти о сотнях тысяч пользователей.

OpenAI утверждает, что система способна распознавать тревожные сигналы и реагировать на них «безопасно и сочувственно». В таких случаях чат-бот предлагает пользователям обратиться за профессиональной помощью, предоставляя контакты кризисных служб и психологических линий доверия.

Чтобы повысить точность и этичность подобных ответов, компания создала международную сеть консультантов, включающую более 170 специалистов - психиатров, психологов и врачей общей практики из 60 стран. Они помогают разработчикам вырабатывать корректные сценарии взаимодействия с пользователями, находящимися в состоянии кризиса.

Тем не менее, часть экспертов выразила сомнение в интерпретации данных OpenAI. По оценкам самой компании, 0,15% всех бесед пользователей содержат явные признаки суицидального планирования или намерений. «Даже если доля таких диалогов кажется незначительной, абсолютное число потенциально уязвимых людей впечатляет», - отмечают специалисты в области психического здоровья.

В ответ на критику OpenAI подчеркнула, что последние обновления системы направлены на распознавание косвенных сигналов риска, включая проявления мании, бредовых идей или самоповреждения. В таких случаях ChatGPT «перенаправляет разговоры» в специальные, более безопасные режимы, открывая новое окно и ограничивая доступ к функциям, способным усугубить состояние пользователя.

Публикация этих данных стала частью расширяющейся проверки этических стандартов ИИ-индустрии, в центре которой вопрос ответственности компаний за психологическое воздействие их продуктов на пользователей.

Источник: BBC

Джамиля Суджадинова

Другие новости на эту тему:

Другие новости на эту тему: Просмотров:92

Просмотров:92 Эта новость заархивирована с источника 28 Октября 2025 10:36

Эта новость заархивирована с источника 28 Октября 2025 10:36

Войти

Войти

Online Xəbərlər

Online Xəbərlər Новости

Новости Погода

Погода Магнитные бури

Магнитные бури Время намаза

Время намаза Калькулятор колорий

Калькулятор колорий Драгоценные металлы

Драгоценные металлы Конвертор валют

Конвертор валют Кредитный калькулятор

Кредитный калькулятор Курс криптовалют

Курс криптовалют Гороскоп

Гороскоп Вопрос - Ответ

Вопрос - Ответ Проверьте скорость интернета

Проверьте скорость интернета Радио Азербайджана

Радио Азербайджана Азербайджанское телевидение

Азербайджанское телевидение О нас

О нас

TDSMedia © 2026 Все права защищены

TDSMedia © 2026 Все права защищены

Самые читаемые

Самые читаемые