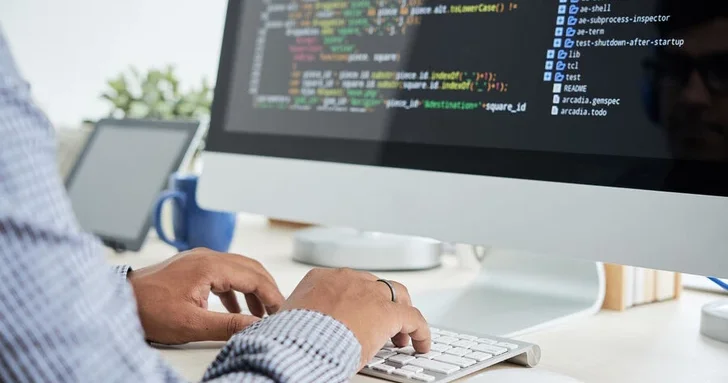

Сгенерированный ИИ код может быть опасен из за выдуманных библиотек

Icma.az сообщает, что по информации сайта Media az.

Большие языковые модели (LLM) при генерации программного кода нередко предлагают использовать сторонние библиотеки, которых в действительности не существует, что открывает злоумышленникам путь к атакам через подмену зависимостей. Об этом сообщает ArsTechnica.

Согласно исследованию, в среднем в каждом втором примере кода, сгенерированном 16 популярными LLM, содержатся ссылки на фиктивные пакеты. В одном из экспериментов было проанализировано более 576 тыс. фрагментов — 440 тыс. зависимостей оказались вымышленными. Причина в том, что обученные на больших объемах текста модели «придумывают» названия библиотек, основываясь на шаблонах, а не на существующих данных из репозиториев.

Такая ошибка может быть использована для проведения атак типа dependency confusion или slopsquatting. Достаточно зарегистрировать пакет с тем же именем, которое «выдумал» ИИ. Если разработчик без проверки установит такой пакет, в его систему может попасть вредоносный код. Уже зафиксированы случаи, когда созданные в рамках исследования тестовые пакеты скачивались десятки тысяч раз.

Особую уязвимость демонстрируют Python и JavaScript, где централизованные репозитории и сторонние зависимости являются нормой. Разработчики часто полагаются на рекомендации ИИ-инструментов, не проверяя вручную существование библиотек.

Эксперты призывают внедрять инструменты мониторинга и анализа безопасности цепочки поставок, а также пересмотреть практику доверия сгенерированных кодов.

Другие новости на эту тему:

Другие новости на эту тему: Просмотров:2414

Просмотров:2414 Эта новость заархивирована с источника 01 Мая 2025 08:31

Эта новость заархивирована с источника 01 Мая 2025 08:31

Войти

Войти

Online Xəbərlər

Online Xəbərlər Новости

Новости Погода

Погода Магнитные бури

Магнитные бури Время намаза

Время намаза Калькулятор колорий

Калькулятор колорий Драгоценные металлы

Драгоценные металлы Конвертор валют

Конвертор валют Кредитный калькулятор

Кредитный калькулятор Курс криптовалют

Курс криптовалют Гороскоп

Гороскоп Вопрос - Ответ

Вопрос - Ответ Проверьте скорость интернета

Проверьте скорость интернета Радио Азербайджана

Радио Азербайджана Азербайджанское телевидение

Азербайджанское телевидение О нас

О нас

TDSMedia © 2026 Все права защищены

TDSMedia © 2026 Все права защищены

Самые читаемые

Самые читаемые