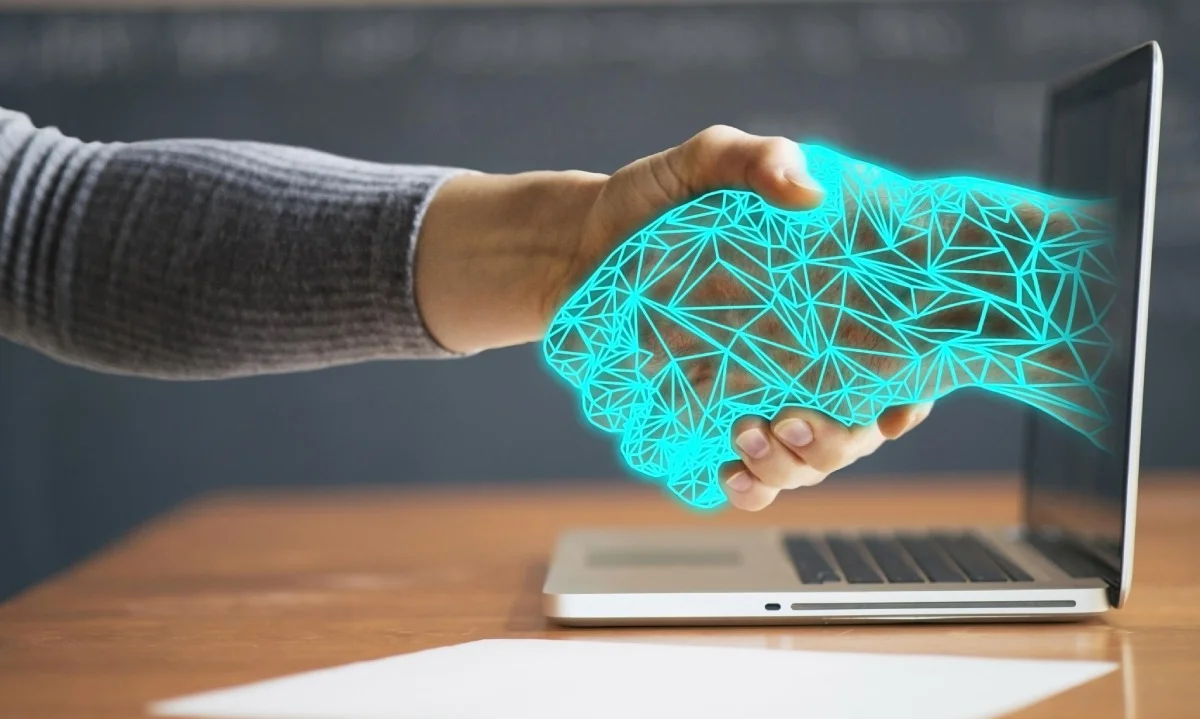

Süni intellektə güvənmək olar? AÇIQLAMA

Icma.az, Metbuat portalından verilən məlumatlara əsaslanaraq xəbər verir.

"ChatGPT" və bu kimi süni intellekt platformalarından şəxsi maraqlar və digər informasiyalar məqsədilə yararlananların sayı kifayət qədər çoxdur. Hətta bu tip platformalar bəzi kəslər üçün dost, psixoloq, müəllim, yaşam koçu rolunu da oynayır deyə onunla bütün şəxsi məlumatlarını paylaşırlar.

Bəs bu baxımdan süni intellektə güvənmək nə qədər doğrudur?

Məsələ ilə bağlı İKT üzrə ekspert Fərhad Mirəliyev Metbuat.az-a açıqlamasında bildirib ki, gündəlik həyatımızda süni intellekt əsaslı həllər həm fərdi şəxslər tərəfindən, həm də hər gün artan temp üzrə korporativ mühitdə şirkətlər tərəfindən istifadə olunmağa başlayır. Bu məsələlərin təhlükəsizliyi ilə bağlı birmənalı demək olmaz ki, hansısa məhsul təhlükəlidir və yaxud da təhlükəsizdir. Burada araşdırma tələb edən məsələlər var:

"Korporativ mühit çox həssasdır və burada süni intellekt vasitəsilə emal olunan datalar çox mühümdür. Hansı datalar süni intellektə təhvil verilə bilər, hansılar gözlənilməlidir və s. - buna artıq həmin müəssisədə informasiya təhlükəsizliyindən məsul şəxslər qərar verir. Amma faktdır ki, süni intellekt əsaslı həlləri tətbiq etməzdən əvvəl korporativ mühitdə mütləq şəkildə informasiya təhlükəsizliyi auditi keçirilməlidir. Həmin auditin nəticəsi olaraq süni intellekt əsaslı məlumatların sızdırılması və sızdırılmanın səviyyəsi və minimallaşdırılması üzərində təhlillər aparılmalıdır. Yalnız bundan sonra qiymətləndirilmə mərhələsinə hansı dataların süni intellekt əsaslı həllərə emal üçün daxil edilməsinə qərar verilə bilər. Əks halda, əgər səthi yanaşma olarsa, o zaman əlbəttə ki, korporativ mühitdə olan datalar üçüncü tərəflərin əlinə keçə bilər. O cümlədən, sənaye casusluğu məqsədilə də bu dataların kimlərsə tərəfindən əldə olunması ehtimalı çox böyükdür".

Ekspertin sözlərinə görə, fərdi şəxslər də süni intellekt əsaslı həllərdən istifadə edərkən ehtiyatlı olmalıdırlar:

"Yəni gündəlik həyatımızda tez-tez elə bir tələbatla rastlaşırıq ki, müəyyən hallarda süni intellekt lazım olur, amma bu həllər bir neçə modifikasiyada bizə əlçatandır. Müxtəlif proqram təminatları var, müxtəlif saytlar var. Mən tövsiyə edərdim ki, istehsalçılar, kodlayıcılar araşdırılsın və etibarlı olan mənbələrdən istifadə olunsun. Misal olaraq, "Open AI" şirkətinin "ChatGPT", "Google" şirkətinin "Gemini", "Microsoft"un "Capilot" məhsulu hazırda digərlərinə nisbətən təhlükəsiz sayılır. Amma nə qədər təhlükəsiz olduğunu araşdırmaq üçün audit həyata keçirmək lazımdır. Son günlərdə də Çin mənşəli “Deepseek" adlı bir süni intellekt həlli artıq istifadəyə verilib və digərlərindən fərqli olaraq onun kodu açıq mənbəlidir. Yəni istənilən adam həmin süni intellektin proqram təminatına nəzər yetirərək oradakı dataların necə emal olunması, kimlərə əlçatan ola bilməsi risklərinin araşdırılması baxımından sərbəstdir.

İnsidentlər bundan əvvəl də olub. 2019-cu ildə bir "FaceApp" proqramı var idi və simanı yaşlı insan formatına gətirirdi. Yəni sən qocalanda necə olacağını görürdün. Sonradan bəlli oldu ki, onlar həmin topladıqları dataları üçüncü tərəflərə satırlarmış. Bundan başqa, "Google" şirkətinin Android əməliyyat sistemi əsaslı telefonlarda istifadə etdiyi "Google Photos" bulud əsaslı proqram təminatında da bir xəta aşkarlanmışdı və bu xəta nəticəsində istifadəçilərin şəkilləri, videoları və s kimi bu kimi dataların naməlum şəxslər tərəfindən istifadə olunması ehtimalı gündəliyə gəlmişdi. Amma bu barədə sonradan heç bir açıqlama verilmədi".

Mütəxəssis qeyd edib ki, istənilən halda risklər var və həmin riskləri azaltmaq üzərində düşünmək lazımdır. Kortəbii istifadə edilərsə, burada tam məsuliyyət həmin istifadəçi vətəndaşın öz üzərinə düşür.

Sevinc İbrahimzadə / Metbuat.az

Bu mövzuda digər xəbərlər:

Bu mövzuda digər xəbərlər: Baxış sayı:198

Baxış sayı:198 Bu xəbər 01 Fevral 2025 22:32 mənbədən arxivləşdirilmişdir

Bu xəbər 01 Fevral 2025 22:32 mənbədən arxivləşdirilmişdir

Daxil ol

Daxil ol

Online Xəbərlər

Online Xəbərlər Xəbərlər

Xəbərlər Hava

Hava Maqnit qasırğaları

Maqnit qasırğaları Namaz təqvimi

Namaz təqvimi Kalori kalkulyatoru

Kalori kalkulyatoru Qiymətli metallar

Qiymətli metallar Valyuta konvertoru

Valyuta konvertoru Kredit Kalkulyatoru

Kredit Kalkulyatoru Kriptovalyuta

Kriptovalyuta Bürclər

Bürclər Sual - Cavab

Sual - Cavab İnternet sürətini yoxla

İnternet sürətini yoxla Azərbaycan Radiosu

Azərbaycan Radiosu Azərbaycan televiziyası

Azərbaycan televiziyası Haqqımızda

Haqqımızda

TDSMedia © 2026 Bütün hüquqlar qorunur

TDSMedia © 2026 Bütün hüquqlar qorunur

Günün ən çox oxunanları

Günün ən çox oxunanları